Dès ce mois de février, l’AI Act (ou règlement IA) devient concret pour les entreprises ! Pas de panique, il s’agit surtout d’éliminer les risques les plus élevés en termes de droits fondamentaux, et de s’assurer que chacun utilise l’IA en toute connaissance de cause.

Les obligations abordées ci-dessous sont les deux premières d’une longue série, et l’application d’autres mesures sont prévues jusqu’en 2027.

Faisons le point sur ce qui change pour vous en tant qu’employeur.

Les mots à retenir : limiter les risques et maitriser les outils

Dès le 2 février 2025, les entreprises qui utilisent l’IA en interne devront mettre en place des actions qui cadrent l’utilisation de l’IA.

Nuançons toutefois cette obligation : les entreprises qui n’utilisent pas l’IA pour le travail quotidien n’ont pas à ajouter cette mesure à leur politique interne.

En bref :

- assurez-vous que vos travailleurs (ou toute personne utilisant l’IA en votre nom) connaissent les tenants et aboutissants des nouveaux outils d’intelligence artificielle. C’est l’occasion d’instaurer une politique interne liée à l’IA.

- bannissez les systèmes IA à risques inacceptables (considérés comme allant à l’encontre des normes et valeurs européennes).

Des connaissances de base en intelligence artificielle

En tant qu’employeur, vous devez vous assurer que vos employés ont en main les outils et les compétences leur permettant une utilisation consciente de l’IA.

Les recommandations restent basiques et n’imposent pas de mesures exactes. Pour l’instant, il s’agit donc surtout de faire appel à son bon sens : les travailleurs ou toute autre personne se servant de l’IA doivent pouvoir utiliser leur esprit critique pour anticiper les biais d’une IA et ses limites en tant que technologie.

Pour encourager ce sens critique, renseignez-vous sur les formations dont pourraient bénéficier vos travailleurs pour maitriser les bases de l’IA d’un point de vue légal.

Une utilisation risquée ?

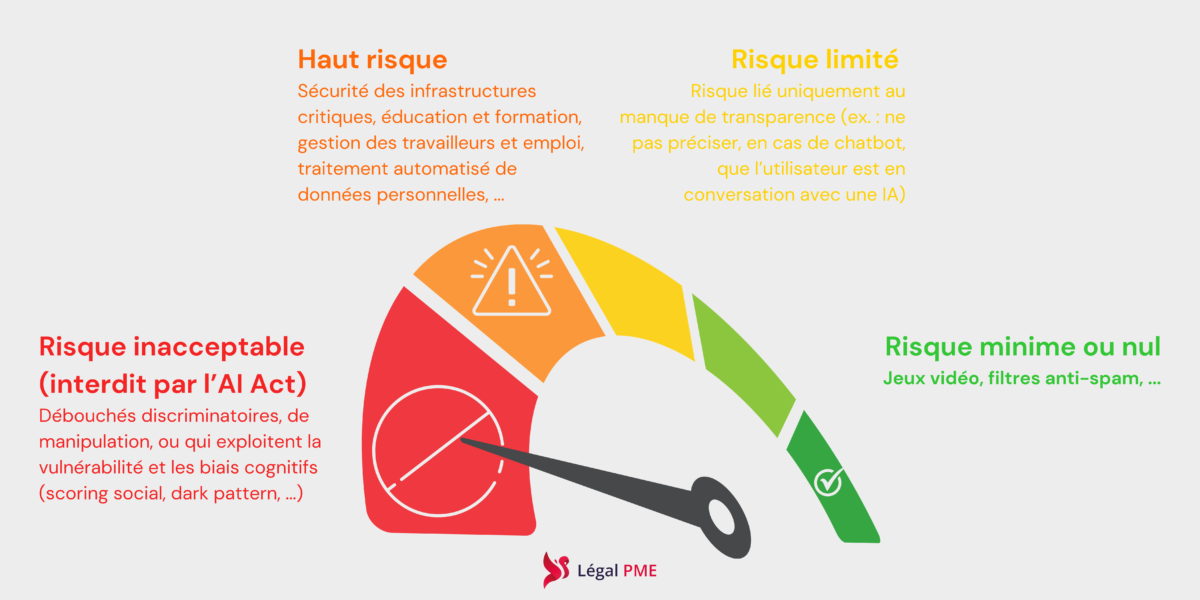

Avec le règlement IA, l’Europe souhaite faire en sorte qu’un minimum de risques soient pris en termes de violation des droits fondamentaux.

Les risques sont classés en classés en 4 catégories. Seuls les systèmes d’IA entrant dans la catégorie « inacceptable » sont interdits.

Quels sont les systèmes IA à risque inacceptable (et donc à bannir) ?

- Les IA aux débouchés discriminatoires ou qui exploitent la vulnérabilité des individus. C’est le cas de la pratique du « scoring social », qui évalue et classe des personnes sur base de données liées à leur comportement social.

- La reconnaissance faciale ou la reconnaissance des émotions.

- Les IA aux fins de manipulation, comme l’utilisation de certains interfaces utilisateurs profitant de leurs biais cognitifs (voir le « dark pattern »).

Les sanctions

Mettez fin à toute utilisation d’un des systèmes repris ci-dessus avant le 2 février. Les amendes en cas de sanctions seront d’application à partir du 2 août 2025. Les entreprises pourront payer des amendes allant jusqu’à 7 % de leur chiffres d’affaire annuel.

Ce que nous faisons pour vous

Légal PME vous conseille et répond à toutes vos questions concernant l’IA.

Charte IA, plan d’action, rédaction ou révision de vos contrats … Nos juristes vous accompagnent dans l’intégration, en toute sécurité, de l’intelligence artificielle dans votre entreprise.

Offert : un audit rapide (15 à 30 minutes en visio)

Legal PME est LE juriste 3.0 qui répond à TOUTES vos questions et vous accompagne dans votre projet IA.

Allons-y !Allons-y !

Et pour être tenu au courant des actualités transmises par Légal PME, inscrivez-vous à la newsletter : un condensé bimensuel d’articles pratiques à destination des entreprises !

Je m'inscris !Je m'inscris !

→ ARTICLES SIMILAIRES DE LÉGAL PME :

- ChatGPT n’est pas juriste

- Mettre en place une “charte IA” : pourquoi et comment ?

- L’AI Act : protecteur de l’avenir numérique

- Les enjeux juridiques de l’Intelligence Artificielle

- Évolution de la société : combiner droit et nouvelles technologies, un mythe ?

- Google Analytics, une utilisation qui risque de coûter cher ?

- La politique de cookies

- Les entreprises face à la Cybercriminalité

- La validité légale des documents électroniques

- Comment enregistrer une marque à différents niveaux et à quelles conditions ?

- Droits d’auteur, trois conditions pour être protégé

- Check-list RGPD : Vérification de la conformité de l’entreprise en 10 étapes